نمی دانم نام فایل Robots.txt را شنیده اید یا نه ! اما همین را بگویم که ساخت فایل Robot.txt و آشنایی با دستورات آن برای مدیریت هر چه بهتر ربات های خزنده، امری ضروری است. پس تا پایان این مقاله با من همراه باشید.

بسیار خوب قبل از هر چیز، خیلی ساده می خواهم به شما بگویم که فایل Robots.txt چیست و چه کاربردی دارد؟

فایل Robots.txt چیست و چه کاربردی دارد؟

همه ما می دانیم که ربات های خزنده موتورهای جست و جو دائماً در حال گشت و گذار در میان صفحات وب هستند و با الگوریتم هایی که برای آن ها تعریف شده، مدام در حال Crawl و یافتن صفحات جدید و بررسی صفحات قدیمی تر در فضای وب هستند.

امّا سوال اینجاست؟ ما چطور می توانیم افسار این ربات ها را برای خزش و بررسی وبسایت خودمان به دست بگیریم؟ چطور می توانیم ربات های خزنده را مدیریت کنیم و با ایجاد دستور العمل هایی برای آن ها، رفتارشان را برای بررسی صفحات وبسایت خودمان بهتر کنترل کنیم. البته در دوره جامع آموزش سئو قسمتی را به طور کامل در مورد نحوه کار با فایل Robots.txt به صورت ویدیویی آموزش داده ام که می توانید مراجعه کنید.

مثلاً فرض کنید که ما نمی خواهیم، خزنده های گوگل به صفحه و یا صفحاتی از وبسایت ما سر بزنند. یا به عنوان مثال مجوّز خزش و بررسی صفحاتی از وبسایت خودمان را به خزنده ها اعلام کنیم. برای ارسال چنین سیگنال هایی به سمت ربات های خزنده، از ایجاد دستوراتی داخل فایل Robots.txt استفاده می کنیم.

در کل ما باید در فرآیند سئو و بهینه سازی وبسایت خودمان، دائماً به این موضوع فکر کنیم که چطور می توانیم بیشتر و بهتر، مدیریت ربات های گوگل را به دست بگیریم و از سرکشی ها و خزش بی مورد ربات ها به مکان های مختلف وبسایتِ ما که اصلاً قصد نداریم در گوگل نمایش داده شوند، جلوگیری کنیم.

بسیار خوب امیدوارم توانسته باشم که به زبان ساده بیان کنم فایل Robot.txt چیست و چه کاربردی دارد.

چرا به ساخت فایل robots.txt نیاز داریم؟

هدف اصلی ما از ساخت فایل Robots.txt این است که بتوانیم رفتار خزنده ها و ربات هایی که به وبسایت ما سر می زنند را کنترل کنیم. برای همین نیاز به یک فایل با پسوند txt داریم که به زبان ربات با خودشان صحبت کنیم بنابراین نیاز به دانستن دستوراتی هست که به کمک آن دستورات می توانیم با زبان ربات ها صحبت کنیم.

امّا دلایل اصلی برای اینکه ما نیاز به ساخت فایل Robots.txt داریم از این قرار است:

- جلوگیری از Crawl یا خزش یک صفحه یا پوشه از وبسایت توسط ربات ها

- مدیریت نمایش صفحه یا صفحاتی از وبسایت در نتایج جست و جو

- کنترل ترافیک ربات هایی که به وبسایت ما سر می زنند

- مدیریت بهتر بودجه خزش یا Crawl Budjet

- جلوگیری از ایندکس محتوای بی کیفیت

- جلوگیری از ایجاد صفحات با محتوای تکراری

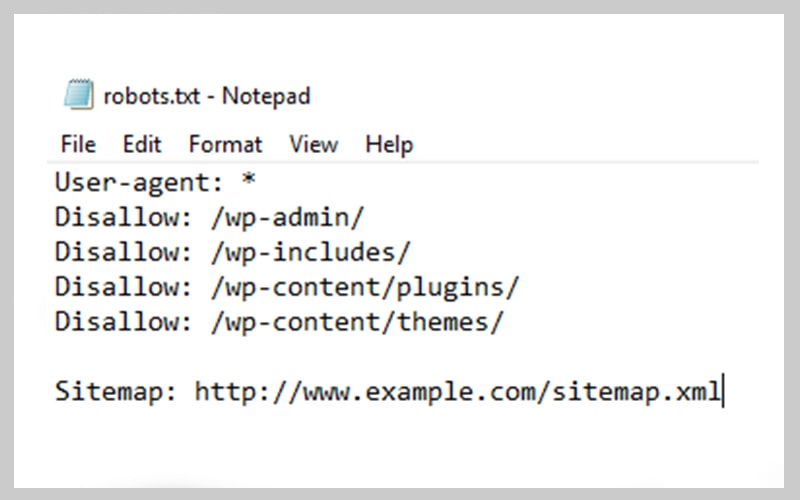

در تصویر زیر نمونه فایل Robots.txt را مشاهده می کنید:

با ربات های گوگل آشنا شویم

موتور جست و جوی گوگل، ربات ها یا خزنده هایی دارد که به صورت روزانه به هزاران صفحه وب سر می زنند و محتوای آن صفحات را خزش و اندکس می کنند. بد نیست که با مهم ترین ربات های گوگل آشنا شوید تا بدانید دقیقاً گوگل به کمک چه ربات هایی شروع به Crawl وبسایت شما می کند.

- Googlebot : این ربات گوگل صفحات محتلف وبسایت را خزش و ایندکس می کند

- Adsense : بررسی صفحات با هدف نمایش تبلیغات

- Google Image : رباتی که ماموریت بررسی تصاویر را بر عهده دارد

- Google video : رباتی که ویدیوهای داخل صفحات وب را بررسی می کند

- GoogleNews : رباتی برای خزش و ایندکس صفحات وبسایت های خبری

آشنایی با بودجه خزش یا Crawl budget

بسیار خوب تا به اینجا با انواع ربات ها و خزنده های گوگل آشنا شدیم و فهمیدیم که این ربات ها به صورت روزانه صفحات وبسایت ما را بررسی می کنند و هر کدام با توجه به وظیفه ای که بر عهده دارند، محتوای صفحات وب را خزش و ایندکس می کنند.

امّا در این میان مفهومی به نام بودجه خزش یا Crawl budget وجود دارد که به تعداد صفحاتی از وبسایت شما گفته می شود که ربات Googlebot خزش و واکاوی می کند که این بودجه خزش بر اساس حجم صفحات وبسایت شما، ریتم تولید محتوا، زمان به روزرسانی محتوای سایت، تعداد . کیفیت بک لینک های هدایت شده به سمت صفحات وبسایت شما و… سنجیده می شود.

دستورات Robots.txt برای مدیریت بهتر ربات ها

در بین همه دستوراتی که برای ربات های خزنده تعریف می شود ۴ دستور از همه مهم تر است که به تعریف هر کدام خواهیم پرداخت:

- User-agent : برای تعیین نام رباتی که دستورات را برای مدیریت آن می نویسیم.

- Disallow : پوشه ها و یا صفحاتی که ربات مجوز دسترسی به آن را ندارد.

- Allow : مواردی که ربات اجازه دارد بررسی کند.

- Sitemap: برای اینکه نقشه سایت یا sitemap وبسایت خود را به ربات ها معرفی کنید.

تعیین دستور User-agent برای مدیریت ربات ها

گفتیم که این دستور برای صدا زدن نوع رباتی است که می خواهیم دستور مورد نظر را برایش تعیین کنیم.

این دستور دو مقدار دارد که به این شکل مشخص می شود:

مقدار اول: استفاده از (*) به معنای این است که دستورات بعدی برای همه ربات ها اعمال شود.

User-agent:*

امّا اگر دستورات را فقط برای ۱ نوع ربات بخواهیم اجرا کنیم، لازم است تا نام آن را صدا بزنیم.

مثلاً در مورد زیر، دستورات فقط ربات Googleboat اجرا می شود.

User-agent:Googleboat

تعیین دستور Disallow برای عدم دسترسی ربات به یک مسیر خاص

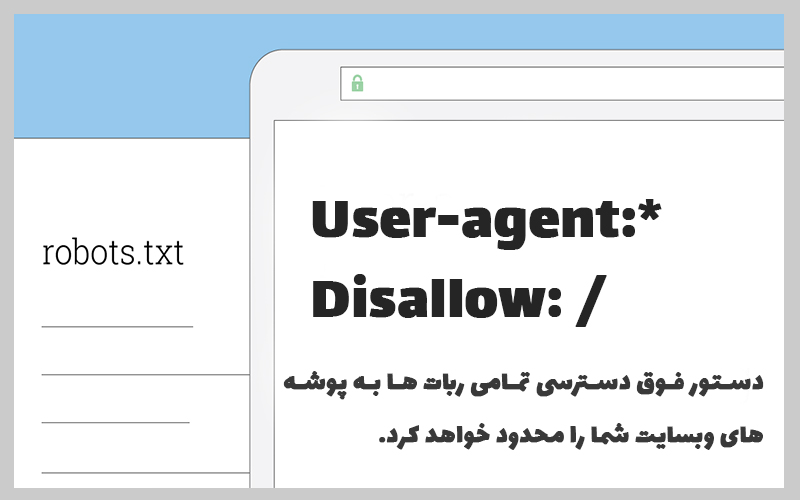

فرض کنید که شما می خواهید دسترسی همه ربات های گوگل را به یک مسیر خاص از وبسایت خودتان محدود کنید. در مثال زیر ما دسترسی همه ربات های گوگل به پوشه admin را بسته ایم و هیچ کدام از ربات ها به این پوشه سر نخواهند زد. این دستور برای زمانی است که می خواهیم دسترسی ربات های گوگل را به یک پوشه خاص محدود کنیم.

User-agent: *

Disallow: /admin

با توجه به مثال فوق، دسترسی تمامی ربات ها به پوشه admin بسته خواهد شد.

هشدار: دستور مشاهده شده در تصویر فوق، دسترسی ربات ها را به تمامی پوشه های وبسایت شما محدود خواهند کرد، پس در استفاده از دستورات فایل Robots.txt نهایت دقّت را داشته باشید.

دستور Allow راهی برای مجوّز دسترسی ربات ها

در مقابل دستوری داریم که به ربات های گوگل مجوز دسترسی به پوشه و یا فایل هایی را که ما می خواهیم برای گوگل صادر خواهیم کرد.

برای اینکه نحوه کارکرد این دستور در فایل Robots.txt را بهتر متوجه شوید،برای شما یک مثال می زنم.

فرض کنید ما یک پوشه در root هاست خود داریم به نام “Picture” و به کمک دستور Disallow دسترسی همه ربات ها را به این پوشه بسته ایم.

User-agent:*

Disallow: /picture

حال می خواهیم فقط دسترسی ربات ها را برای ۲ تصویر باز کنیم. یعنی به ربات ها اجازه دهیم تا فقط به دو تصویر Pic1.jpeg و Pic2.jpeg دسترسی داشته باشند.

User-agent:*

Disallow: /photos

Allow: / picture / Pic1.jpeg

Allow: / picture / Pic2.jpeg

دستور فوق به همه ربات ها اعلام می کند که مجوز دسترسی به هیچ یک از تصاویر داخل پوشه Picture را ندارند به جز دو تصویر Pic1.jpeg و Pic2.jpeg که می توانند بررسی کنند.

دستور sitemap برای معرفی نقشه سایت به گوگل

اما یکی دیگر از دستوراتی که در فایل Robots.txt استفاده از دستور sitemap است.

البته ما راه و روش های دیگری هم داریم که بتوان نقشه سایت یا سایت مپ خود را به گوگل متصل کنیم. مثلاً یکی از بهترین روش ها استفاده از google Search console برای این کار است.

Sitemap: https://mywebsite.com/sitemap.xml

مثلاً با کمک دستور فوق می توان فایل سایت مپ وبسایت خودمان را به گوگل معرفی نمود.

در ادامه خواهیم دید که چگونه می توان فایل Robots.txt را پیدا کرد و چگونه می توان چنین فایلی را ایجاد نمود.

نحوه ساخت یک فایل Robots.txt

سوالی که در اینجا مطرح می شود این است که فایل Robots.txt چگونه ساخته می شود؟

قبل از اینکه به چنین سوالی پاسخ دهیم، بیایید تا ببینیم که فایل Robots.txt دقیقاً در کجای وبسایت ما وجود دارد و چگونه می توان به این فایل دسترسی داشت.

کافیه که شما آدرس mywebsite.com/robots.txt را در مرورگر خود تایپ کنید و کلید Enter را بزنید. البته توجه کنید که باید به جای عبارت “mywebsite” نام دامنه وبسایت خودتان را قرار دهید.

اینجا دو حالت پیش می آید، یا اینکه چنین فایلی بر روی هاست شما وجود ندارد و شما با خطای ۴۰۴ رو به رو خواهید شد و یا اینکه دستورات داخل این فایل برای شما بر روی مرورگر ظاهر خواهد شد.

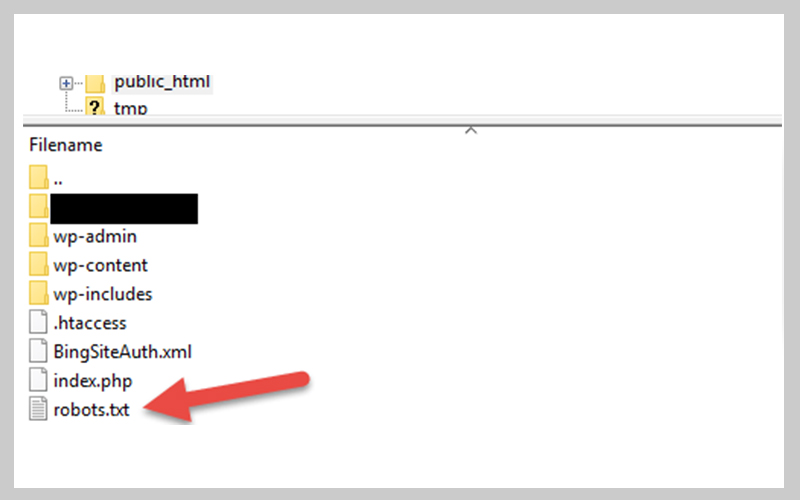

راه دیگر این است که به Root یا ریشه اصلی هاست وبسایت خود مراجعه کنید و بررسی کنید که آیا فایل Robots.txt در هاست شما وجود دارد یا خیر.

چگونه یک فایل Robots.txt بسازیم؟

کار بسیار ساده تر از آن چیزی است که فکر می کنید. کافیست یک برنامه ویرایشگر متن (Notepad) را باز کنید و فایل را با نام robots.txt و با فرمت UTF-8 خروجی بگیرید. حال این فایل را در سرور میزبانی وبسایت خود آپلود کنید، به همین راحتی شما بهترین فایل Robots.txt دنیا را ساخته اید.

دقت کنید که اگر داخل این فایل هیچ دستوری ننویسید،در واقع مثل این است که هیچ محدودیّت یا دستوری برای ربات ها ایجاد نکرده اید.

در تصویر زیر یک نمونه فایل Robots.txt را در ریشه هاست یک وبسایت مشاهده می کنید.

با توجه به تصویر فوق، یک فایل متنی “robots.txt” در ریشه هاست وجود دارد که می توانید مشاهده کنید.

نحوه تست فایل Robots.txt

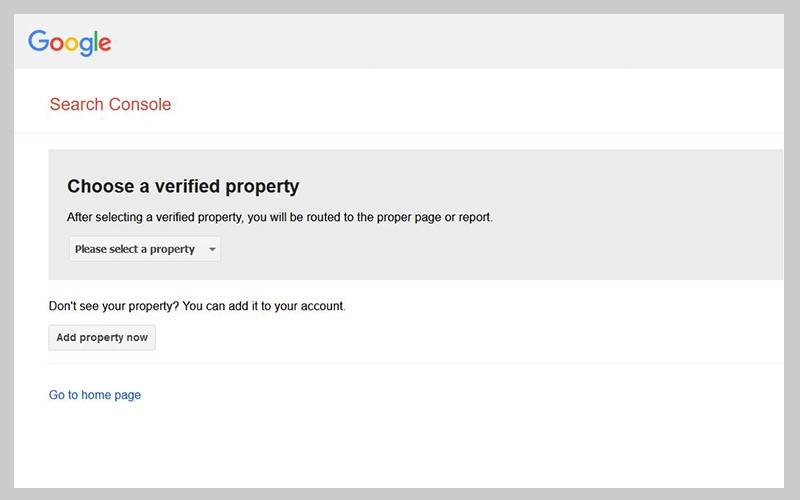

بسیار خوب الان وقت آن رسیده است تا فایل robots.txt ساخته شده وبسایت خود را تست کنیم و این کار را می توانیم به کمک ابزار آنلاین گوگل به نام robots testing tools انجام دهیم.

به این ابزار مراجعه کنید و با توجه به تصویر زیر، زمانی که در جیمیل متصل شده به سرچ کنسول وبسایت خود لاگین باشید، می توانید Property یا همان وبسایت مورد نظر خود را انتخاب کرده و سپس به صفحه نمایش محتویّات فایل Robots.txt مراجعه کنید.

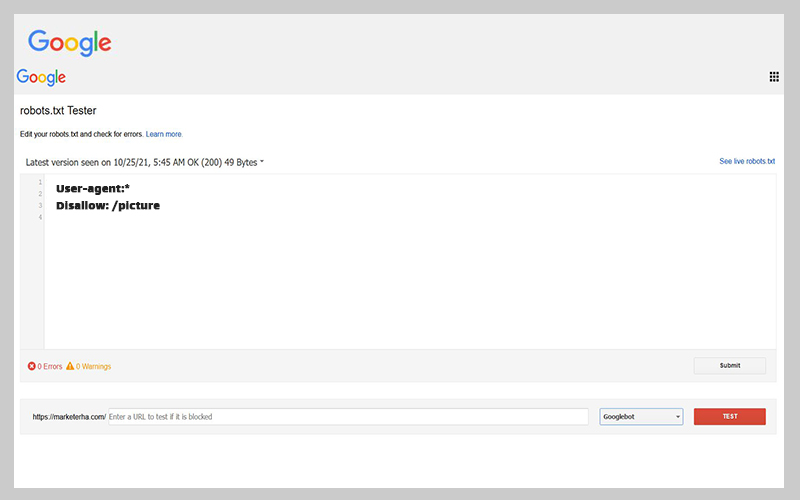

با توجه به تصویر زیر شما می توانید محتویّات فایل robots.txt را تغییر دهید و روی دکمه Submit کلیک کنید.

ضمن اینکه در پایین این صفحه نوار تست وجود دارد و با انتخاب ربات گوگل می توانید مشخص کنید که دستورات برای ربات انتخاب شده به درستی اجرا می شود یا خیر.

همانطور که می بینید، در پایین صفحه سمت چپ، ارورها و هشدارهایی را برای شما نمایش می دهد که با بررسی آن ها می توانید متوجه شوید که تعداد Error ها و Warning های این فایل چند مورد است.

کافیه نام فایل robots.txt را در باکس فوق وارد کرده و ربات مورد نظر خود را انتخاب کنید و سپس روی دکمه “”TEST کلیک کنید. با این کار، ابزار تست شروع به یافتن خطاها و هشدارها کرده و اگر موردی در دستورات نباشد، عبارت “Allowd” بر روی دکمه نمایش داده خواهد شد.

ساخت فایل Robots.txt در وردپرس

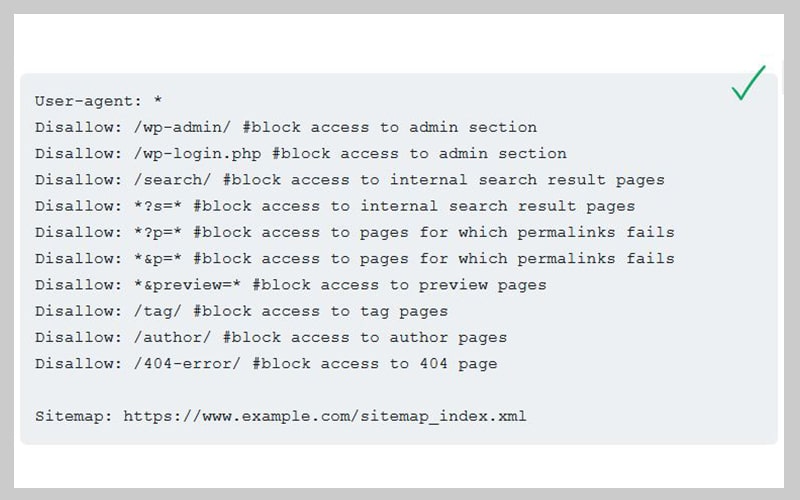

نحوه ساخت این فایل در وردپرس فرقی با سایر سیستم های مدیریت محتوا ندارد، اما مهم دستورات این فایل است که برای یک سیستم وردپرسی کمی متفاوت است.

به عنوان مثال در یک سایت وردپرسی، تگ یا برچسب ها وجود دارد که شاید مورد علاقه شما برای ایندکس شدن توسط گوگل نباشد یا اینکه نخواهید ربات های گوگل به ادمین وبسایت شما سر بزنند و…

دستورات زیر، نمونه ای از دستوراتی است که برای فایل Robots.txt یک فایل وردپرسی تدوین شده است.

البته این نکته را داخل پرانتز خدمت شما بگویم، به صورت پیش فرض ربات ها معمولاً به پوشه هایی که نیاز به نام کاربری و رمز عبور دارند سر نخواهند زد برای همین لازم نیست که حتماً در فایل Robots.txt یک سایت وردپرسی از دستور محدود کردن خزش پوشه هایی همچون wp-admin استفاده کنید.

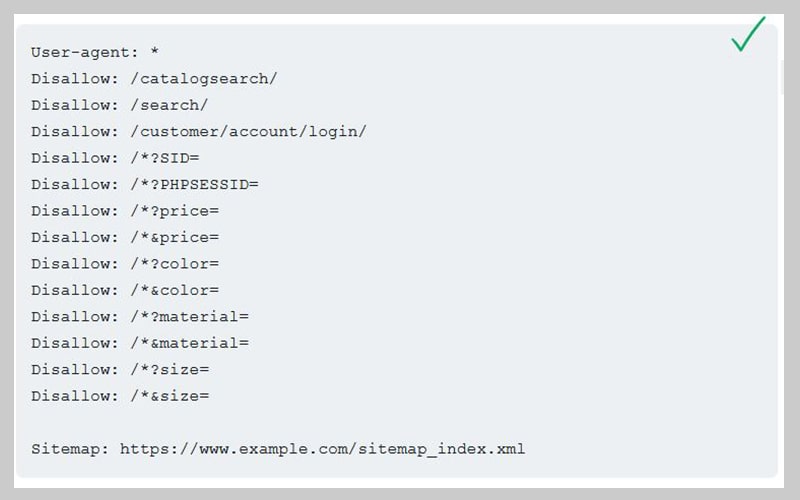

ساخت فایل Robots.txt در مجنتو

برای سیستم مدیریت محتوای مجنتو هم می توان دستورات منحصر به فردی نوشت و رفتار ربات های گوگل بر روی این سیستم مدیریت محتوا را کنترل کرد.

با توجه به تصویر فوق، تمام دسترسی ها برای فیلترهایی که مربوط به تنظیم رنگ ها، قیمت، سایز و متریال هستند برای ربات های گوگل مسدود شده و این مورد از ایجاد محتوای تکراری جلوگیری خواهد کرد.

سایز فایل Robots.txt باید چقدر باشد؟

در حال حاضر، ربات های گوگل فایل رباتی که حداکثر ۵۰۰ کیلوبایت حجم داشته باشد را بررسی خواهند کرد و اگر از این مقدار عبور کند، احتمال دارد که دیگر توسّط ربات های گوگل دیده نشود. بنابراین بهتر است در صورتی که مجبور هستید دستورات زیادی در فایل Robotx.txt قرار دهید، به حجم آن دقّت کنید تا از ۵۰۰ کیلوبایت عبور نکند.

چرا فایل Robots.txt برای سئو ضروری است؟

دقّت کنید که هر اندازه وبسایت بزرگتر باشد، قطعاً مدیریت بخش های مختلف آن هم گسترده تر است. بنابراین داشتن فایل ربات و مدیریت بخش هایی که نباید ربات های گوگل به ان سر بزنند، امری ضروری است.

با مثال های بیشتر آشنا شوید

در ادامه چند مثال دیگر برای دستورات فایل ربات را با هم بررسی خواهیم کرد که می تواند به شما کمک کند تا در صورت نیاز از آن ها برای مدیریت ربات های گوگل استفاده کنید.

همه ربات های گوگل به جز Googlebot به پوشه ها دسترسی دارند

User-agent: googlebot

/:Disallow

User-agent: googlebot-news

:Disallow

فقط دو ربات Googlebot و Slurp به پوشه ها دسترسی ندارند

User-agent: Slurp

User-agent: googlebot

/:Disallow

همه ربات ها به دستورات زیر دسترسی نخواهند داشت

User-agent: *

Disallow: /admin

Disallow: /private

همه ربات های گوگل به یک فایل pdf خاص دسترسی نخواهند داشت

User-agent: *

Disallow: /directory/some-pdf.pdf

سخن آخر

در این مقاله سعی کردم به طور کامل آموزش دهم که فایل Robots.txt چیست و چه کاربردی دارد. امیدوارم این مقاله برای شما مفید بوه باشه. این نکته را هم در پایان بگویم که بررسی دستورات این فایل را جدی بگیرید به خصوص اگر وبسایت خود را از شرکت طراحی سایتی دریافت می کنید، لازم است تا حتماً نگاهی به دستورات فایل Robots.txt بیندازید.

خوشحال میشیم اگر نظر خودتون رو در پایین این مقاله درج کنید.

![تدوین استراتژی تولید محتوا [ ۱۰۰ درصد کاربردی ] https://masireseo.com/content-marketing-plan/](https://masireseo.com/wp-content/uploads/2022/04/تدوین-استراتژی-تولید-محتوا-100x56.webp)

![فرق هاست ایران و خارج چیست؟ +[مزایا و معایب] https://masireseo.com/differences-between-iran-and-foreign-host/](https://masireseo.com/wp-content/uploads/2023/02/hosting-100x56.jpg)

![الگوریتم کبوتر گوگل چیست؟ Google’s Pigeon [ برگ برنده سئو محلی! ] https://masireseo.com/google-pigeon-algorithm/](https://masireseo.com/wp-content/uploads/2022/09/google-pingeton-100x56.jpg)

![تفاوت SEM و SEO چیست؟ [ هر آنچه باید بدانید ] https://masireseo.com/seo-vs-sem/](https://masireseo.com/wp-content/uploads/2022/08/seo-sem-100x56.jpg)